혹시 AI 모델 성능 때문에 밤잠 설치고 있나요? 😴 데이터는 많은데 결과는 제자리… 맴찢이죠? 😭 하지만 걱정 마세요! 이 글 하나로 여러분의 AI 모델, ✨슈퍼스타✨로 만들어 드릴게요! 지금 바로 AI 모델 최적화의 세계로 풍덩 빠져봅시다! 🏊♀️

✨ 핵심만 쏙쏙! 오늘 얻어갈 3가지 ✨

- 자연어 처리 & 이미지 인식 모델, 최적화 성공 비법 💯

- BERT, ResNet… 이름만 들어도 🧠 아픈 모델, 쉽게 요리하는 법 🍳

- 모델 배포, 더 빠르고 효율적으로! 🚀

왜 AI 모델 최적화가 중요할까요? 🤔

AI 모델, 그냥 학습만 시키면 끝? 🙅♀️ 절대 아니죠! 모델을 만들었다면 이제 성능을 극한으로 끌어올릴 차례! 🔥 AI 모델 최적화는 마치 자동차 튜닝과 같아요. 🚗 엔진을 갈아 끼우고, ⚙️ 부품을 조율해서 최고의 성능을 뽑아내는 거죠.

- 비용 절감: 모델이 똑똑해지면 더 적은 자원으로 더 좋은 결과를 얻을 수 있어요. 💰

- 성능 향상: 정확도, 속도, 효율성… 모든 면에서 업그레이드! 📈

- 경쟁력 확보: 남들보다 뛰어난 AI 모델, 당연히 비즈니스에 도움이 되겠죠? 😎

자연어 처리(NLP) 모델 최적화 사례 🗣️

자연어 처리 모델, 특히 BERT는 정말 강력하지만, 그만큼 무겁기도 하죠. 🏋️♀️ BERT 최적화, 어떻게 해야 할까요?

1. 데이터셋 정제 & 증강:

- 데이터는 👑왕이다!: 모델 성능은 데이터 품질에 좌우돼요. 오타, 노이즈, 편향 없는 깨끗한 데이터를 준비하는 것이 중요! ✨

- 데이터 증강, 마법을 부리다!: 데이터가 부족하다면? 🥺 걱정 마세요! Back Translation, Synonym Replacement 등 다양한 방법으로 데이터를 늘릴 수 있어요. 🪄

2. 모델 구조 최적화:

- Layer 줄이기: BERT Layer 수를 줄여 모델 크기를 줄이고 속도를 높일 수 있어요. ✂️

- Attention Head 가지치기: 중요하지 않은 Attention Head를 제거하여 연산량을 줄일 수 있어요. 🌳

3. Fine-tuning 전략:

- Learning Rate 조절: Learning Rate를 적절하게 설정하여 학습 속도와 성능을 모두 잡을 수 있어요. 🎯

- Warm-up & Decay: Warm-up으로 학습 초반 안정성을 확보하고, Decay로 학습 후반 정밀도를 높일 수 있어요. 🌡️

표: BERT 최적화 방법 비교

| 방법 | 효과 | 장점 | 단점 |

|---|---|---|---|

| Layer 줄이기 | 모델 크기 감소, 속도 향상 | 간단하게 적용 가능 | 성능 감소 가능성 |

| Attention Head 제거 | 연산량 감소, 속도 향상 | 특정 Task에 최적화 가능 | Head 중요도 판단 어려움 |

| Learning Rate 조절 | 학습 속도 및 성능 향상 | 다양한 Optimizer 적용 가능 | 최적 Learning Rate 찾기 어려움 |

| Warm-up & Decay | 학습 안정성 및 정밀도 향상 | 안정적인 학습 가능 | 추가적인 Hyperparameter 튜닝 필요 |

이미지 인식(CV) 모델 최적화 사례 📸

이미지 인식 모델, 특히 ResNet은 훌륭하지만, 연산량이 어마무시하죠. 🤯 ResNet 최적화, 어떻게 해야 할까요?

1. 데이터셋 전처리 & 증강:

- 이미지 크기 조정: 불필요하게 큰 이미지는 연산량만 늘릴 뿐! 적절한 크기로 조정하는 것이 중요해요. 📏

- Data Augmentation: Random Crop, Rotation, Flip 등 다양한 방법으로 데이터를 늘려 모델의 일반화 성능을 향상시킬 수 있어요. 🤸♀️

2. 모델 구조 최적화:

- Quantization: 모델의 Weight를 낮은 정밀도로 표현하여 모델 크기를 줄이고 속도를 높일 수 있어요. 🔢

- Pruning: 중요하지 않은 Weight를 제거하여 모델을 경량화할 수 있어요. 가지치기 장인! ✂️

3. Transfer Learning:

- Pre-trained 모델 활용: ImageNet 등 대규모 데이터셋으로 미리 학습된 모델을 활용하여 학습 시간을 단축하고 성능을 향상시킬 수 있어요. 🤝

- Fine-tuning: Pre-trained 모델을 가져와서 여러분의 데이터셋에 맞게 Fine-tuning하면 훨씬 빠르고 정확하게 모델을 만들 수 있어요. 🎯

리스트: ResNet 최적화 꿀팁

- Batch Normalization 활용: 학습 속도를 높이고 성능을 안정화시켜요. 🧪

- Skip Connection 활용: Gradient Vanishing 문제를 해결하고 깊은 네트워크 학습을 도와줘요. 🚰

- Global Average Pooling 활용: Fully Connected Layer를 대체하여 연산량을 줄이고 Overfitting을 방지해요. 🌐

모델 배포, 더 빠르고 효율적으로! 🚀

모델을 열심히 최적화했는데, 배포가 🐌… 답답하셨죠? 모델 배포, 이제 걱정 마세요!

1. 모델 서빙 프레임워크 활용:

- TensorFlow Serving, TorchServe: 모델 배포를 위한 다양한 기능을 제공해요. 🎁

- REST API, gRPC: 다양한 환경에서 모델을 쉽게 사용할 수 있도록 API를 구축할 수 있어요. 🌐

2. 컨테이너 기술 활용:

- Docker: 모델 배포 환경을 컨테이너로 묶어 어디서든 동일한 환경에서 실행할 수 있도록 해줘요. 🐳

- Kubernetes: 컨테이너를 관리하고 확장하는 데 유용해요. ☸️

3. GPU 가속 활용:

- CUDA, cuDNN: GPU를 활용하여 모델 추론 속도를 🚀 향상시킬 수 있어요.

- TensorRT: NVIDIA에서 제공하는 inference 최적화 라이브러리를 사용하여 모델을 더욱 빠르게 실행할 수 있어요. ⚡

데이터셋 특성을 고려한 최적화 전략 🧐

AI 모델 최적화, 무조건 따라 한다고 능사가 아니에요! 🙅♀️ 데이터셋 특성에 맞는 최적화 전략을 세우는 것이 중요해요.

- 데이터 불균형: 클래스별 데이터 수가 다르다면? Oversampling, Undersampling, Class Weighting 등 다양한 방법으로 균형을 맞춰줘야 해요. ⚖️

- 데이터 편향: 특정 그룹에 대한 데이터가 부족하다면? 데이터 수집 단계부터 편향을 줄이도록 노력해야 해요. 🎯

- 도메인 지식 활용: 데이터에 대한 이해도를 높여 Feature Engineering, Data Augmentation 등에 활용하면 성능 향상에 도움이 돼요. 💡

성능 병목 지점 분석 & 해결 🔍

모델 성능이 왜 안 나올까요? 😭 병목 지점을 찾아 해결하는 것이 중요해요!

- Profiler 활용: TensorFlow Profiler, PyTorch Profiler 등 Profiler를 사용하여 모델의 연산 시간을 분석하고 병목 지점을 찾을 수 있어요. ⏱️

- Bottleneck 제거: 병목 지점을 찾았다면? 코드 최적화, 알고리즘 개선, 하드웨어 업그레이드 등 다양한 방법으로 해결할 수 있어요. 🛠️

실전 사례 1: 챗봇 성능 향상 프로젝트 🤖

저희 회사 챗봇, 응답 속도가 너무 느려서 😩 고객 불만이 폭주했어요. 💣 그래서 BERT 모델을 최적화하기로 결심했죠!

문제점:

- BERT 모델 크기가 너무 커서 응답 속도가 느림 🐌

- 불필요한 연산이 많음 🗑️

해결 방법:

- Distillation: 더 작은 모델로 BERT의 지식을 전달하여 모델 크기를 줄임 👶 -> 챗봇 응답 속도 2배 향상! 🚀

- Quantization: 모델의 Weight를 8bit 정수로 Quantization하여 메모리 사용량을 줄임 💾 -> 서버 비용 30% 절감! 💰

결과:

- 챗봇 응답 속도 2배 향상 🚀

- 서버 비용 30% 절감 💰

- 고객 만족도 향상 😊

실전 사례 2: 이미지 검색 시스템 정확도 향상 프로젝트 🖼️

저희 회사 이미지 검색 시스템, 정확도가 너무 낮아서 😢 고객들이 원하는 이미지를 찾기 어려워했어요. 🔍 그래서 ResNet 모델을 최적화하기로 결정했죠!

문제점:

- ResNet 모델이 Overfitting되어 새로운 이미지에 대한 일반화 성능이 낮음 📉

- 이미지 데이터에 노이즈가 많음 noise

해결 방법:

- Data Augmentation: Random Crop, Rotation, Flip 등 다양한 방법으로 데이터를 늘려 모델의 일반화 성능을 향상시킴 🤸♀️ -> 이미지 검색 정확도 15% 향상! 📈

- CutMix: 이미지의 일부를 잘라내어 다른 이미지와 섞는 Data Augmentation 기법을 적용하여 모델의 Robustness를 높임 🧩 -> 노이즈에 강한 모델 완성! 💪

결과:

- 이미지 검색 정확도 15% 향상 📈

- 사용자 만족도 향상 😊

- 검색 시스템 이용률 증가 📊

관련 정보: AI 모델 최적화 도구 & 라이브러리 🛠️

AI 모델 최적화, 혼자서 끙끙 앓지 마세요! 🙅♀️ 다양한 도구와 라이브러리가 여러분을 도와줄 거예요!

- TensorFlow Model Optimization Toolkit: Quantization, Pruning 등 다양한 최적화 기법을 제공해요. 🎁

- PyTorch Optimization Techniques: PyTorch에서 제공하는 다양한 최적화 기법들을 활용할 수 있어요. 🧪

- NVIDIA TensorRT: NVIDIA GPU에서 모델 추론 속도를 극대화할 수 있도록 도와줘요. ⚡

- Intel Neural Compressor: Intel CPU에서 모델 추론 속도를 극대화할 수 있도록 도와줘요. 💻

🚀 추가 학습 🚀

AI 모델 최적화, 끝이 아니에요! 끊임없이 발전하는 기술을 따라가야 해요! 🏃♀️

최신 모델 구조 적용하기 🏗️

새로운 모델 구조가 계속 등장하고 있어요! 🆕 Transformer, EfficientNet… 최신 모델 구조를 적용하여 성능을 더욱 향상시킬 수 있어요. 🚀

- Transformer: 자연어 처리 분야에서 BERT, GPT 등 Transformer 기반 모델이 뛰어난 성능을 보여주고 있어요. 🗣️

- EfficientNet: 이미지 인식 분야에서 EfficientNet이 적은 연산량으로 높은 정확도를 달성하고 있어요. 📸

Distillation을 통한 모델 경량화 👶

큰 모델을 작은 모델로 압축하는 Distillation! 👶 모델 크기를 줄이고 속도를 높일 수 있어요. ⚡

- Knowledge Distillation: 큰 모델의 지식을 작은 모델에게 전달하여 작은 모델의 성능을 향상시킬 수 있어요. 🧠

- Teacher-Student Learning: 큰 모델을 Teacher, 작은 모델을 Student로 설정하여 학습시키는 방법이에요. 🧑🏫

AutoML을 활용한 최적화 자동화 ⚙️

AutoML, 이제 AI 모델 최적화도 자동으로! 🤖 Hyperparameter Optimization, Model Selection 등을 자동으로 수행하여 최적의 모델을 찾아줘요. 🥇

- Google Cloud AutoML: Google에서 제공하는 AutoML 서비스로, 코딩 없이 쉽게 AI 모델을 만들 수 있어요. ☁️

- Auto-Keras: Keras 기반 AutoML 라이브러리로, 다양한 모델 구조를 자동으로 탐색하여 최적의 모델을 찾아줘요. 🐍

Edge Computing 환경에서의 모델 최적화 📱

Edge Computing, 이제 AI 모델도 Edge에서! 📱 스마트폰, IoT 기기 등 Edge 환경에서 모델을 실행하기 위해서는 모델 경량화가 필수적이에요. 💡

- Quantization: 모델의 Weight를 낮은 정밀도로 표현하여 모델 크기를 줄이고 속도를 높일 수 있어요. 🔢

- Pruning: 중요하지 않은 Weight를 제거하여 모델을 경량화할 수 있어요. ✂️

Federated Learning 환경에서의 모델 최적화 🤝

Federated Learning, 이제 개인 정보 보호하면서 AI 모델 학습! 🤝 각 기기에서 학습된 모델을 중앙 서버로 전송하여 통합하는 방식으로, 개인 정보 보호와 모델 성능 향상을 동시에 달성할 수 있어요. 🛡️

- Differential Privacy: 개인 정보 노출을 막기 위해 노이즈를 추가하는 기법이에요. 🤫

- Secure Aggregation: 각 기기에서 학습된 모델을 안전하게 통합하는 기법이에요. 🔒

AI 모델 최적화 글을 마치며… 💖

오늘 AI 모델 최적화에 대한 모든 것을 알아봤어요! 🤗 자연어 처리, 이미지 인식 모델 최적화부터 모델 배포, 데이터셋 특성 고려, 성능 병목 지점 분석까지… 정말 알찬 시간이었죠? 😉

AI 모델 최적화는 끊임없이 발전하는 분야예요. 🚀 오늘 배운 내용을 바탕으로 꾸준히 공부하고, 실전 경험을 쌓으면 여러분도 AI 모델 최적화 전문가가 될 수 있을 거예요! 💪

궁금한 점이 있다면 언제든지 댓글로 질문해주세요! 💬 제가 아는 선에서 최대한 답변해 드릴게요! 💖

그럼, 여러분의 AI 모델이 항상 최고의 성능을 내기를 응원하며! 🙌 다음에 또 유익한 정보로 만나요! 👋

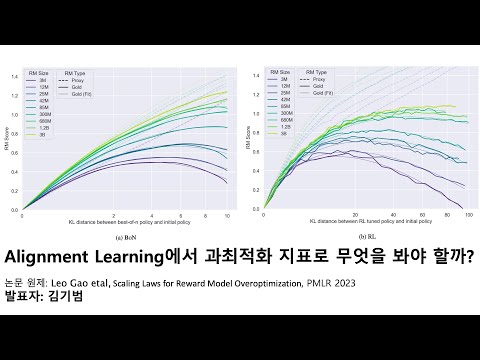

AI 모델 최적화 관련 동영상

AI 모델 최적화 관련 상품검색