어머, 혹시 아직도 챗GPT만 쓰고 계신 건 아니죠? 😱 AI 시대, 텍스트 데이터를 내 손으로 분석하고 감성까지 파악한다면 얼마나 멋질까요? ✨ 뒤쳐질까 조마조마한 당신을 위해, 자연어 처리(NLP) 입문부터 실습까지, 쉽고 재미있게 알려드릴게요! 😉

📌 오늘, 딱 3가지만 기억하세요!

- 텍스트 데이터, 내 손안에! 텍스트 데이터 형식을 이해하고, 정규 표현식으로 원하는 정보만 쏙쏙 뽑아내는 마법! 🧙♀️

- 감성 분석, 어렵지 않아요! Python NLP로 긍정/부정 감성을 분석하고, 나만의 감성 분석 모델 만들기! 🤖

- 더 깊이, 더 넓게! Word Embedding과 Transformer 모델로 NLP 실력 레벨업! 🚀

자연어 처리(NLP)란 무엇일까요? 🤔

자연어 처리(NLP, Natural Language Processing)는 컴퓨터가 인간의 언어를 이해하고 분석할 수 있도록 하는 AI 프로그래밍 분야예요. 챗GPT처럼 텍스트를 생성하는 것뿐만 아니라, 텍스트 데이터에서 유용한 정보를 추출하고 의미를 해석하는 데에도 활용되죠. 🤗 예를 들어, 고객 리뷰를 분석해서 어떤 점이 좋고 어떤 점이 개선되어야 하는지 파악하거나, 뉴스 기사를 읽고 어떤 사건이 발생했는지 요약하는 것도 NLP의 영역에 속해요.

텍스트 데이터, 종류가 다양해요! 🗂️

텍스트 데이터는 우리 주변에 정말 많아요! 🤩 웹 페이지, 소셜 미디어 게시글, 이메일, 뉴스 기사, 책, 논문 등 거의 모든 종류의 문서가 텍스트 데이터라고 할 수 있죠. 텍스트 데이터는 크게 정형 데이터와 비정형 데이터로 나눌 수 있어요.

- 정형 데이터: 데이터베이스에 저장된 형태로, 열(column)과 행(row)으로 구성되어 있어요. 예를 들어, 상품명, 가격, 판매량 등이 정형 데이터에 해당하죠.

- 비정형 데이터: 텍스트, 이미지, 오디오, 비디오 등 형식이 정해져 있지 않은 데이터예요. 텍스트 데이터 중에서는 블로그 글, 트위터 게시글, 고객 리뷰 등이 비정형 데이터에 속해요.

우리가 이번 글에서 주로 다룰 텍스트 데이터는 비정형 데이터랍니다. 😊 비정형 데이터는 정형 데이터와 달리 데이터베이스에 바로 저장하기 어렵기 때문에, NLP 기술을 활용해서 데이터를 분석하고 의미를 추출해야 해요.

정규 표현식, 텍스트 데이터 마법 지팡이! 🪄

정규 표현식(Regular Expression)은 특정 패턴을 가진 문자열을 찾거나 바꾸는 데 사용하는 강력한 도구예요. 텍스트 데이터에서 원하는 정보만 쏙쏙 뽑아낼 수 있는 마법 지팡이 같은 존재죠! ✨ 예를 들어, 이메일 주소나 전화번호만 추출하고 싶을 때, 정규 표현식을 사용하면 아주 간단하게 해결할 수 있어요.

정규 표현식은 다양한 기호와 문자를 조합해서 패턴을 정의하는데, 처음에는 좀 어렵게 느껴질 수 있어요. 😅 하지만 몇 가지 기본 규칙만 익히면 금방 익숙해질 수 있답니다.

| 기호 | 의미 | 예시 |

|---|---|---|

. | 임의의 문자 1개 | a.c는 "abc", "adc", "a1c" 등과 매칭 |

* | 앞의 문자가 0번 이상 반복 | a*b는 "b", "ab", "aab", "aaab" 등과 매칭 |

+ | 앞의 문자가 1번 이상 반복 | a+b는 "ab", "aab", "aaab" 등과 매칭 (b는 안됨) |

? | 앞의 문자가 0번 또는 1번 나타남 | a?b는 "b", "ab"와 매칭 |

[] | 문자 집합 중 하나 | [abc]는 "a", "b", "c" 중 하나와 매칭 |

[^] | 문자 집합에 속하지 않는 문자 | [^abc]는 "a", "b", "c"를 제외한 모든 문자와 매칭 |

d | 숫자 | d+는 1개 이상의 숫자로 이루어진 문자열과 매칭 |

w | 문자 + 숫자 + "_" | w+는 1개 이상의 문자, 숫자, "_"로 이루어진 문자열과 매칭 |

s | 공백 문자 (space, tab, newline) | s+는 1개 이상의 공백 문자와 매칭 |

() | 그룹으로 묶기 | (abc)+는 "abc", "abcabc", "abcabcabc" 등과 매칭 |

| | 또는 (or) | a|b는 "a" 또는 "b"와 매칭 |

^ | 문자열의 시작 | ^abc는 "abc"로 시작하는 문자열과 매칭 |

$ | 문자열의 끝 | abc$는 "abc"로 끝나는 문자열과 매칭 |

예제:

- 이메일 주소 추출:

w+@w+.w+ - 전화번호 추출:

d{2,3}-d{3,4}-d{4}

정규 표현식은 온라인에서 다양한 튜토리얼과 연습 문제를 찾을 수 있으니, 꾸준히 연습해보세요! 💪

텍스트 데이터, 인코딩은 왜 중요할까요? 🤔

텍스트 데이터는 컴퓨터에 저장될 때 특정 방식으로 인코딩되어야 해요. 인코딩 방식에 따라 같은 텍스트도 다르게 표현될 수 있기 때문에, 인코딩을 제대로 이해하지 못하면 텍스트가 깨져서 보이거나 오류가 발생할 수 있어요. 😥

가장 흔하게 사용되는 인코딩 방식은 UTF-8이에요. UTF-8은 유니코드 문자를 표현하는 방식 중 하나로, 전 세계의 모든 문자를 표현할 수 있다는 장점이 있어요. 😎 하지만 UTF-8 외에도 EUC-KR, CP949 등 다양한 인코딩 방식이 존재하기 때문에, 텍스트 데이터를 처리할 때는 어떤 인코딩 방식으로 되어 있는지 확인하는 것이 중요해요.

만약 텍스트 파일의 인코딩 방식을 모르는 경우, 파이썬의 chardet 라이브러리를 사용해서 인코딩을 추정할 수 있어요.

import chardet

with open('text_file.txt', 'rb') as f:

result = chardet.detect(f.read())

print(result['encoding'])불용어(Stopwords) 처리, 왜 해야 할까요? 🗑️

불용어(Stopwords)는 텍스트 분석에서 큰 의미를 가지지 않는 단어들을 말해요. 예를 들어, "a", "the", "is", "are" 같은 관사나 조사, 접속사 등이 불용어에 해당하죠. 불용어는 텍스트 데이터에서 자주 등장하지만, 실제 의미 분석에는 큰 영향을 주지 않기 때문에 제거하는 것이 좋아요. 🙅♀️ 불용어를 제거하면 텍스트 데이터의 크기를 줄일 수 있고, 분석 결과의 정확도를 높일 수 있답니다.

파이썬의 NLTK(Natural Language Toolkit) 라이브러리는 다양한 언어의 불용어 목록을 제공해요.

from nltk.corpus import stopwords

stop_words = set(stopwords.words('english')) # 영어 불용어 목록

print(stop_words)감성 분석, 긍정 vs 부정! 😍😡

감성 분석(Sentiment Analysis)은 텍스트 데이터에 나타난 감정이나 의견을 분석하는 기술이에요. 긍정적인 감성인지, 부정적인 감성인지, 아니면 중립적인 감성인지 파악하는 것이죠. 🤗 감성 분석은 고객 리뷰 분석, 소셜 미디어 여론 분석, 영화 평점 예측 등 다양한 분야에서 활용될 수 있어요.

감성 분석은 크게 두 가지 방법으로 수행할 수 있어요.

- 사전 기반 감성 분석: 감성 사전을 이용해서 텍스트에 나타난 단어들의 감성 점수를 합산하는 방식이에요. 예를 들어, "good"은 긍정적인 단어이고, "bad"는 부정적인 단어이기 때문에, 텍스트에 "good"이 많이 나타나면 긍정적인 감성으로 판단하는 것이죠.

- 머신러닝 기반 감성 분석: 머신러닝 모델을 학습시켜서 텍스트의 감성을 분류하는 방식이에요. 텍스트 데이터를 학습시킨 후, 새로운 텍스트가 주어졌을 때 긍정/부정을 예측하는 것이죠.

Python NLP, 실습으로 익혀봐요! 🐍

이제 파이썬을 이용해서 간단한 NLP 실습을 해볼까요? 🤩 이번 실습에서는 NLTK 라이브러리를 사용해서 텍스트 데이터를 전처리하고, 감성 분석을 수행해볼 거예요.

1단계: NLTK 라이브러리 설치

pip install nltk2단계: 필요한 데이터 다운로드

import nltk

nltk.download('punkt') # 토큰화를 위한 데이터

nltk.download('stopwords') # 불용어 목록

nltk.download('vader_lexicon') # 감성 사전3단계: 텍스트 데이터 전처리

from nltk.tokenize import word_tokenize

from nltk.corpus import stopwords

text = "This is a sample sentence. It's a beautiful day!"

# 1. 토큰화 (Tokenization): 문장을 단어 단위로 분리

tokens = word_tokenize(text)

print("토큰:", tokens)

# 2. 불용어 제거 (Stopwords Removal)

stop_words = set(stopwords.words('english'))

filtered_tokens = [token for token in tokens if token.lower() not in stop_words]

print("불용어 제거:", filtered_tokens)4단계: 감성 분석

from nltk.sentiment.vader import SentimentIntensityAnalyzer

analyzer = SentimentIntensityAnalyzer()

scores = analyzer.polarity_scores(text)

print("감성 분석 결과:", scores)감성 분석 결과는 pos (긍정), neg (부정), neu (중립), compound (종합 점수)로 나타나요. compound 점수가 0.05보다 크면 긍정적인 감성, -0.05보다 작으면 부정적인 감성, 그 사이면 중립적인 감성으로 판단할 수 있어요.

Word Embedding, 단어의 의미를 숫자로! 🔢

Word Embedding은 단어의 의미를 벡터 공간에 표현하는 기술이에요. 비슷한 의미를 가진 단어들은 벡터 공간에서 가까운 거리에 위치하게 되죠. Word Embedding은 텍스트 분류, 기계 번역, 질의 응답 등 다양한 NLP task에서 성능 향상에 기여해요.

대표적인 Word Embedding 방법으로는 Word2Vec과 GloVe가 있어요.

- Word2Vec: 주변 단어를 이용해서 단어의 의미를 학습하는 방법이에요. CBOW(Continuous Bag-of-Words)와 Skip-gram 두 가지 모델이 있어요.

- GloVe: 전체 코퍼스에서의 단어 동시 발생 통계를 이용해서 단어의 의미를 학습하는 방법이에요.

Transformer 모델, NLP의 새로운 시대! 🚀

Transformer 모델은 Attention 메커니즘을 기반으로 하는 딥러닝 모델이에요. 기존의 RNN(Recurrent Neural Network) 모델보다 훨씬 더 긴 문맥을 잘 파악할 수 있고, 병렬 처리가 가능해서 학습 속도가 빠르다는 장점이 있어요. Transformer 모델은 챗GPT, BERT, GPT-3 등 다양한 NLP 모델의 기반이 되고 있으며, NLP 분야에 혁명을 일으키고 있답니다.

Transformer 모델은 크게 Encoder와 Decoder로 구성되어 있어요. Encoder는 입력 문장을 벡터 표현으로 변환하고, Decoder는 벡터 표현을 이용해서 출력 문장을 생성해요. Attention 메커니즘은 Encoder와 Decoder가 서로 정보를 주고받을 때 어떤 단어에 집중해야 하는지를 알려주는 역할을 해요.

사례: 챗GPT, 자연어 처리 기술의 집약체! 🤖

챗GPT는 OpenAI에서 개발한 대규모 언어 모델(LLM, Large Language Model)이에요. Transformer 모델을 기반으로 수많은 텍스트 데이터를 학습해서, 인간과 유사한 텍스트를 생성할 수 있어요. 챗GPT는 질문에 답변하거나, 글을 요약하거나, 코드를 작성하는 등 다양한 작업을 수행할 수 있으며, 우리의 일상생활과 업무에 많은 도움을 주고 있답니다.

챗GPT는 자연어 처리 기술의 발전 가능성을 보여주는 대표적인 사례라고 할 수 있어요. 앞으로도 챗GPT와 같은 강력한 언어 모델들이 계속해서 등장할 것이고, 우리의 삶을 더욱 편리하게 만들어줄 것으로 기대돼요.

추가 학습 주제

텍스트 요약 (Text Summarization) 📝

텍스트 요약은 긴 텍스트 문서의 핵심 내용을 짧게 줄이는 기술입니다. 뉴스 기사 요약, 보고서 요약, 논문 요약 등에 활용될 수 있습니다. 텍스트 요약은 크게 추출적 요약(Extractive Summarization)과 생성적 요약(Abstractive Summarization)으로 나눌 수 있습니다. 추출적 요약은 원본 텍스트에서 중요한 문장들을 그대로 추출하여 요약문을 만드는 방식이고, 생성적 요약은 원본 텍스트의 내용을 이해하고 새로운 문장을 생성하여 요약문을 만드는 방식입니다. 최근에는 Transformer 모델을 기반으로 하는 생성적 요약 모델들이 많이 연구되고 있습니다.

기계 번역 (Machine Translation) 🌐

기계 번역은 한 언어의 텍스트를 다른 언어의 텍스트로 자동으로 번역하는 기술입니다. 구글 번역, 파파고 등이 대표적인 기계 번역 서비스입니다. 기계 번역은 초기에는 통계 기반 기계 번역(SMT, Statistical Machine Translation) 방식이 주로 사용되었지만, 최근에는 신경망 기반 기계 번역(NMT, Neural Machine Translation) 방식이 주류를 이루고 있습니다. 신경망 기반 기계 번역은 주로 Sequence-to-Sequence 모델을 사용하며, Transformer 모델이 등장하면서 번역 품질이 크게 향상되었습니다.

텍스트 생성 (Text Generation) ✍️

텍스트 생성은 주어진 컨텍스트(context)에 따라 자연스러운 텍스트를 생성하는 기술입니다. 챗GPT와 같은 대규모 언어 모델(LLM)들이 대표적인 텍스트 생성 모델입니다. 텍스트 생성 모델은 주로 Transformer 모델을 기반으로 학습되며, 다양한 길이와 스타일의 텍스트를 생성할 수 있습니다. 텍스트 생성 기술은 챗봇, 콘텐츠 생성, 스토리텔링 등 다양한 분야에 활용될 수 있습니다.

질의 응답 (Question Answering) ❓

질의 응답은 주어진 질문에 대해 정확한 답변을 찾아내는 기술입니다. 질의 응답 시스템은 주로 정보 검색(Information Retrieval)과 자연어 이해(Natural Language Understanding) 기술을 결합하여 구현됩니다. 질의 응답은 크게 추출적 질의 응답(Extractive Question Answering)과 생성적 질의 응답(Generative Question Answering)으로 나눌 수 있습니다. 추출적 질의 응답은 주어진 문서에서 답변을 찾아서 추출하는 방식이고, 생성적 질의 응답은 질문에 대한 답변을 직접 생성하는 방식입니다.

챗봇 (Chatbot) 💬

챗봇은 사용자와 텍스트 또는 음성으로 대화할 수 있는 컴퓨터 프로그램입니다. 챗봇은 고객 상담, 예약, 상품 추천 등 다양한 업무를 자동화할 수 있습니다. 챗봇은 크게 규칙 기반 챗봇(Rule-based Chatbot)과 인공지능 기반 챗봇(AI-based Chatbot)으로 나눌 수 있습니다. 규칙 기반 챗봇은 미리 정의된 규칙에 따라 대화를 진행하는 방식이고, 인공지능 기반 챗봇은 자연어 처리 기술을 이용하여 사용자의 질문을 이해하고 적절한 답변을 생성하는 방식입니다. 최근에는 Transformer 모델을 기반으로 하는 대규모 언어 모델(LLM)을 활용한 챗봇들이 많이 등장하고 있습니다.

AI 프로그래밍 글을 마치며… 📝

자, 이렇게 해서 자연어 처리(NLP) 입문부터 감성 분석 실습, 그리고 확장 학습까지 함께 알아봤어요! 어떠셨나요? 🤗 처음에는 어렵게 느껴졌을 수도 있지만, 차근차근 따라오다 보니 NLP의 매력에 푹 빠지셨을 거라고 믿어요! 😉

AI 프로그래밍은 끊임없이 발전하는 분야이기 때문에, 꾸준히 공부하고 새로운 기술을 익히는 것이 중요해요. 오늘 배운 내용을 바탕으로, 더욱 깊이 있는 NLP 연구를 진행하고, 실생활에 유용한 AI 서비스를 만들어보는 건 어떨까요? 🤩

혹시 궁금한 점이나 더 알고 싶은 내용이 있다면 언제든지 댓글로 남겨주세요! 😊 여러분의 AI 여정을 항상 응원할게요! 💖

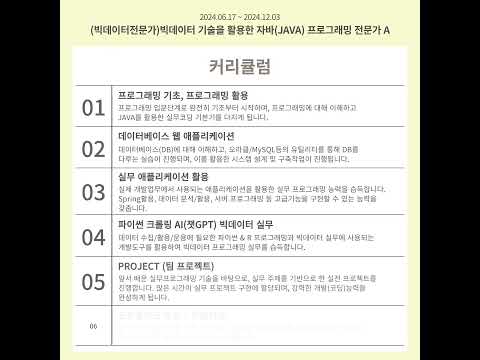

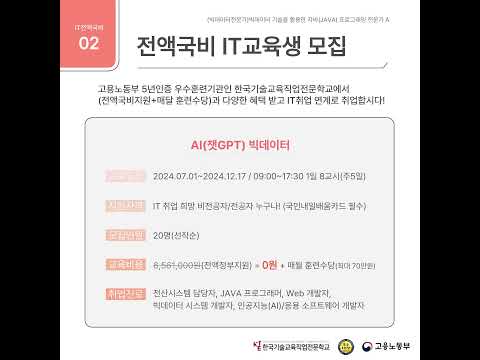

AI 프로그래밍 관련 동영상

AI 프로그래밍 관련 상품검색