혹시 RNN 배우다가 갑자기 🤯 멘붕 온 적 있어? 분명 잘 되는 것 같았는데, 어느 순간 성능이 뚝 떨어지고… "아, 내가 뭘 잘못한 거지?" 밤새도록 고민했던 적 있다면, 당신만 그런 게 아니에요! 😅 많은 개발자들이 RNN의 고질적인 문제, 바로 Vanishing Gradient 때문에 좌절하곤 하죠. 하지만 걱정 마세요! 👋 이 글 하나로 Vanishing Gradient, 확실하게 해결하고 RNN 실력, 한 단계 업그레이드할 수 있어요! 지금 바로 시작해볼까요? 🤩

오늘 우리는 이걸 배울 거예요!

- Vanishing Gradient, 왜 문제일까? 🤔 원인부터 해결책까지 싹 다 파헤쳐 보기!

- Gradient Clipping, LSTM, GRU! 🛠️ Vanishing Gradient 잡는 히든 카드 전격 분석!

- RNN, 제대로 쓰려면? 꿀팁 대방출! 🍯 모델 구조부터 Learning Rate까지, 실전 노하우 공개!

Vanishing Gradient, 도대체 왜? 🤯

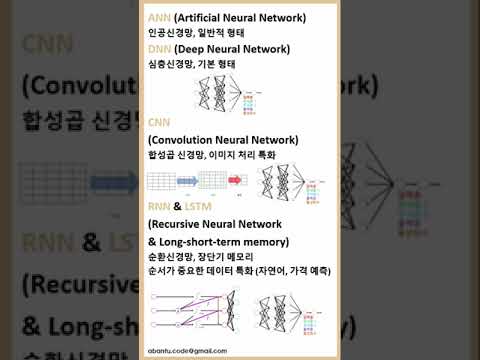

순환 신경망 (RNN) 기술은 시퀀스 데이터를 처리하는 데 아주 강력한 도구예요. 텍스트 번역, 음성 인식, 주가 예측 등 다양한 분야에서 활약하고 있죠. 그런데 RNN을 훈련하다 보면, 학습이 제대로 안 되는 경우가 종종 발생해요. 😭 그 원인 중 하나가 바로 Vanishing Gradient 문제랍니다.

Vanishing Gradient는 간단히 말해서, 역전파 과정에서 Gradient가 점점 작아져서 앞쪽 Layer까지 제대로 전달되지 않는 현상이에요. 마치 메아리가 점점 작아져서 결국 들리지 않게 되는 것과 비슷하죠. 🗣️➡️🔇 Gradient가 제대로 전달되지 않으면, 앞쪽 Layer들은 제대로 학습을 못 하게 되고, 결국 모델 전체의 성능이 떨어지는 거예요. 📉

왜 이런 일이 생기는 걸까요? 🤔 RNN은 시퀀스 데이터를 처리하기 위해, 각 Time Step마다 Hidden State를 업데이트하면서 정보를 전달해요. 이 과정에서 Activation Function을 거치게 되는데, Sigmoid나 Tanh 같은 Activation Function은 입력값이 아주 크거나 아주 작을 때, Gradient가 0에 가까워지는 특징이 있어요. 0에 가까운 값들이 계속 곱해지다 보면, Gradient가 기하급수적으로 작아지는 거죠. 😥

Backpropagation과 Gradient Descent, 핵심 개념 짚어보기 🧐

Vanishing Gradient를 제대로 이해하려면, Backpropagation과 Gradient Descent에 대한 기본적인 이해가 필요해요. 마치 자동차를 고치려면 엔진의 작동 원리를 알아야 하는 것과 같죠. 🚗🔧

Backpropagation (역전파)은 모델의 예측값과 실제값 사이의 오차를 계산하고, 이 오차를 바탕으로 모델의 파라미터(Weight, Bias)를 업데이트하는 과정이에요. 오차를 계산할 때는 Loss Function을 사용하고, 오차를 파라미터에 미분한 값을 Gradient라고 불러요. Gradient는 Loss Function을 가장 빠르게 감소시키는 방향을 나타내죠. 마치 나침반과 같은 역할을 하는 거예요. 🧭

Gradient Descent (경사하강법)은 Gradient를 이용해서 Loss Function을 최소화하는 파라미터를 찾는 최적화 알고리즘이에요. Gradient의 반대 방향으로 조금씩 이동하면서, Loss Function이 가장 낮은 지점을 찾아가는 거죠. 마치 산에서 가장 낮은 곳을 찾아 내려가는 것과 비슷해요. ⛰️🚶♂️

Backpropagation과 Gradient Descent는 뗄레야 뗄 수 없는 관계예요. Backpropagation을 통해 Gradient를 계산하고, Gradient Descent를 통해 파라미터를 업데이트하는 과정을 반복하면서, 모델은 점점 더 정확한 예측을 할 수 있게 되는 거죠. 마치 자전거를 타는 것과 같아요. 페달을 밟아 앞으로 나아가고, 방향을 조절하면서 원하는 목적지까지 가는 거죠. 🚲

Gradient Clipping: Gradient 폭주를 막아라! 💥➡️🛡️

Vanishing Gradient와는 반대로, Gradient가 너무 커져서 학습이 불안정해지는 Gradient Exploding 문제도 있어요. Gradient Exploding은 마치 브레이크가 고장난 자동차처럼, 제어하기가 아주 어렵죠. 🚗💨 Gradient Clipping은 Gradient가 너무 커지는 것을 막아주는 안전 장치와 같은 역할을 해요. 🔒

Gradient Clipping은 Gradient의 Norm(크기)이 특정 Threshold를 넘지 않도록 제한하는 기법이에요. Gradient의 Norm이 Threshold보다 크면, Gradient를 Threshold로 나눠서 크기를 줄여주는 거죠. 마치 물 풍선이 너무 커지지 않도록 물을 조금 빼주는 것과 같아요. 🎈✂️

Gradient Clipping은 구현하기도 아주 간단해요. PyTorch나 TensorFlow 같은 Deep Learning Framework에서는 이미 Gradient Clipping 기능을 제공하고 있답니다. 코드를 몇 줄만 추가하면, Gradient Exploding 문제를 간단하게 해결할 수 있어요. 💻

Gradient Clipping, 이렇게 쓰면 좋아요!

- RNN, 특히 LSTM이나 GRU 모델에서 효과적이에요. 🧠

- Threshold 값은 실험적으로 결정해야 해요. 🤔 너무 작으면 학습이 느려지고, 너무 크면 효과가 없을 수 있어요.

- Regularization 기법(L1, L2 Regularization)과 함께 사용하면 더 좋은 효과를 얻을 수 있어요. ➕

LSTM: 장기 의존성 문제 해결사! 🦸♂️

LSTM(Long Short-Term Memory)은 Vanishing Gradient 문제를 해결하기 위해 개발된 특별한 RNN 아키텍처예요. LSTM은 Hidden State 대신 Cell State라는 것을 사용하는데, Cell State는 정보를 오랫동안 기억할 수 있는 능력이 뛰어나답니다. 마치 기억력이 아주 좋은 사람과 같아요. 🧠💡

LSTM은 Forget Gate, Input Gate, Output Gate라는 세 개의 Gate를 가지고 있어요. 이 Gate들은 Cell State에 정보를 추가하거나 삭제하는 역할을 해요. Forget Gate는 Cell State에서 어떤 정보를 잊을지 결정하고, Input Gate는 Cell State에 어떤 정보를 추가할지 결정하고, Output Gate는 Cell State에서 어떤 정보를 출력할지 결정하는 거죠. 마치 정보 필터와 같은 역할을 하는 거예요. 🎛️

LSTM은 복잡한 구조를 가지고 있지만, Vanishing Gradient 문제를 효과적으로 해결하고, 장기 의존성 문제를 해결하는 데 아주 뛰어난 성능을 보여줘요. 텍스트 번역, 음성 인식 등 다양한 분야에서 널리 사용되고 있답니다. 🌐

LSTM, 이것만 기억하세요!

- Cell State: 정보를 오랫동안 기억하는 핵심! 🗝️

- Forget Gate, Input Gate, Output Gate: 정보 필터 3총사! 🎛️🎛️🎛️

- 장기 의존성 문제 해결에 특화! 🏆

GRU: LSTM 간소화 버전! 🚀

GRU(Gated Recurrent Unit)는 LSTM의 간소화 버전이라고 할 수 있어요. LSTM보다 구조가 간단하고, 파라미터 수가 적어서 학습 속도가 빠르다는 장점이 있어요. 마치 경량 스포츠카와 같아요. 🏎️💨

GRU는 Reset Gate와 Update Gate라는 두 개의 Gate를 가지고 있어요. Reset Gate는 이전 Hidden State를 얼마나 잊을지 결정하고, Update Gate는 Hidden State를 얼마나 업데이트할지 결정하는 역할을 해요. LSTM보다 Gate 수가 적지만, Vanishing Gradient 문제를 해결하고, 장기 의존성 문제를 해결하는 데 충분한 성능을 보여준답니다. 💪

GRU는 LSTM과 거의 비슷한 성능을 내면서도, 학습 속도가 빠르기 때문에, 많은 개발자들이 선호하는 RNN 아키텍처예요. 특히 데이터가 부족하거나, 빠른 실험이 필요할 때 유용하게 사용할 수 있어요. 🧪

GRU, 이렇게 활용해 보세요!

- LSTM과 비슷한 성능, 더 빠른 학습 속도! ⚡

- Reset Gate, Update Gate: 핵심 Gate 2개! ⚙️⚙️

- 데이터 부족하거나, 빠른 실험 필요할 때! 🎯

RNN, 제대로 쓰려면? 꿀팁 대방출! 🍯

Vanishing Gradient 문제를 해결하는 것도 중요하지만, RNN을 제대로 사용하는 것도 중요해요. 마치 좋은 도구를 가지고 있어도, 사용하는 방법을 모르면 제대로 활용할 수 없는 것과 같죠. 🧰

1. 적절한 Learning Rate 설정: Learning Rate는 모델의 학습 속도를 결정하는 중요한 Hyperparameter예요. Learning Rate가 너무 크면, Overfitting이 발생할 수 있고, 너무 작으면 학습이 너무 느려질 수 있어요. 적절한 Learning Rate를 찾는 것이 중요하죠. Learning Rate Scheduler를 사용해서, 학습 과정에서 Learning Rate를 동적으로 조절하는 것도 좋은 방법이에요. ⏰

2. 모델 구조 선택: RNN, LSTM, GRU 등 다양한 모델 구조 중에서, 문제에 맞는 적절한 모델을 선택해야 해요. 텍스트 번역처럼 복잡한 문제에는 LSTM이나 GRU가 좋고, 간단한 시퀀스 데이터 처리에는 RNN도 충분할 수 있어요. 모델 구조를 복잡하게 만들수록, Overfitting이 발생할 가능성이 높아지므로, 가능한 한 간단한 모델을 사용하는 것이 좋아요. 🧱

3. Regularization 기법 활용: Regularization은 Overfitting을 방지하고, 모델의 일반화 성능을 높이는 데 도움이 되는 기법이에요. L1 Regularization, L2 Regularization, Dropout 등 다양한 Regularization 기법을 사용할 수 있어요. Regularization은 모델의 복잡도를 줄여주고, Overfitting을 방지하는 효과가 있답니다. 🛡️

4. Batch Normalization 적용: Batch Normalization은 각 Layer의 입력값을 정규화해서, 학습을 안정화시키는 데 도움이 되는 기법이에요. Batch Normalization은 Gradient Vanishing/Exploding 문제를 완화하고, Learning Rate를 높이는 효과도 있어요. Batch Normalization은 모델의 성능을 향상시키는 데 아주 유용한 기법이랍니다. 📈

5. Early Stopping 활용: Early Stopping은 검증 데이터(Validation Data)를 이용해서, 모델의 성능이 더 이상 향상되지 않으면 학습을 중단하는 기법이에요. Early Stopping은 Overfitting을 방지하고, 모델의 일반화 성능을 높이는 데 도움이 된답니다. 🛑

Attention 메커니즘: 중요한 정보에 집중! 👁️

Attention 메커니즘은 RNN의 성능을 향상시키는 데 아주 효과적인 기법이에요. Attention 메커니즘은 모델이 입력 시퀀스에서 중요한 부분에 집중할 수 있도록 도와줘요. 마치 중요한 정보에 형광펜으로 표시하는 것과 같아요. 🖍️

Attention 메커니즘은 텍스트 번역, 이미지 캡셔닝 등 다양한 분야에서 널리 사용되고 있어요. Attention 메커니즘을 사용하면, 모델이 더 정확한 예측을 할 수 있고, 설명 가능성도 높아진답니다. 💡

Attention 메커니즘, 핵심은 이거예요!

- 입력 시퀀스에서 중요한 부분에 집중! 👁️

- 텍스트 번역, 이미지 캡셔닝 등 다양한 분야에 적용! 🌐

- 정확도 향상, 설명 가능성 증가! 🏆

Residual Connection: Gradient 흐름을 원활하게! ➡️

Residual Connection은 모델의 깊이가 깊어질수록 발생하는 Vanishing Gradient 문제를 해결하는 데 도움이 되는 기법이에요. Residual Connection은 Layer의 입력값을 Layer의 출력값에 더해주는 방식으로 작동해요. 마치 고속도로에 지름길을 만들어주는 것과 같아요. 🛣️

Residual Connection은 Gradient가 Layer를 건너뛰어서 직접 앞쪽 Layer로 전달될 수 있도록 해줘요. 이렇게 하면, Gradient가 점점 작아지는 것을 막을 수 있고, 모델의 학습이 더 안정적으로 이루어질 수 있답니다. 💪

Residual Connection, 이렇게 활용하세요!

- 깊은 모델에서 Vanishing Gradient 문제 해결! 🧱➡️🧱

- Gradient 흐름을 원활하게! ➡️

- 모델의 학습 안정성 향상! 📈

사례 1: 챗봇 개발에 RNN 기술 적용하기 🤖

한 IT 회사에서 고객 응대를 위한 챗봇을 개발하게 되었어요. 초기에는 간단한 규칙 기반 챗봇을 사용했지만, 고객들의 다양한 질문에 제대로 답변하지 못하는 경우가 많았죠. 😭 그래서 순환 신경망 (RNN) 기술을 기반으로 한 챗봇을 개발하기로 결정했어요.

가장 먼저, 대화 데이터를 수집하고 전처리하는 작업을 진행했어요. 수집된 데이터는 수천 건의 고객 문의와 상담 내용이었죠. 이 데이터를 이용해서 RNN 모델을 훈련시키기 시작했어요. 하지만 예상대로 Vanishing Gradient 문제가 발생했고, 모델의 성능이 제대로 나오지 않았어요. 🤯

그래서 LSTM을 사용해서 모델을 개선하기로 했어요. LSTM은 Vanishing Gradient 문제를 해결하는 데 효과적인 아키텍처이기 때문이죠. LSTM을 적용한 결과, 모델의 성능이 눈에 띄게 향상되었어요. 챗봇은 고객들의 질문에 더 정확하게 답변할 수 있게 되었고, 고객 만족도도 크게 높아졌답니다. 😄

사례 2: 주가 예측 모델 개발에 RNN 기술 적용하기 📈

한 금융 회사에서 주가 예측 모델을 개발하기 위해 순환 신경망 (RNN) 기술을 사용하기로 결정했어요. 주가 데이터는 시계열 데이터이기 때문에, RNN이 적합하다고 판단했기 때문이죠.

과거 주가 데이터, 거래량, 뉴스 기사 등 다양한 데이터를 수집하고, 이 데이터를 이용해서 RNN 모델을 훈련시키기 시작했어요. 하지만 모델의 성능은 기대에 미치지 못했어요. 특히 장기적인 주가 예측은 정확도가 매우 낮았죠. 📉

그래서 GRU를 사용해서 모델을 개선하기로 했어요. GRU는 LSTM보다 구조가 간단하고, 학습 속도가 빠르다는 장점이 있기 때문이죠. GRU를 적용한 결과, 모델의 성능이 향상되었고, 장기적인 주가 예측 정확도도 높아졌어요. 📈

RNN 관련 추가 학습 주제 📚

RNN 기술은 끊임없이 발전하고 있어요. 앞으로 더 많은 가능성이 열려 있답니다. RNN 관련해서 더 깊이 있는 학습을 원하시는 분들을 위해, 몇 가지 추가 학습 주제를 준비했어요.

양방향 RNN (Bidirectional RNN) ➡️⬅️

양방향 RNN은 입력 시퀀스를 순방향과 역방향으로 모두 처리하는 RNN 아키텍처예요. 양방향 RNN은 문맥 정보를 더 잘 파악할 수 있기 때문에, 텍스트 분류, 개체명 인식 등 다양한 자연어 처리 문제에서 좋은 성능을 보여준답니다. 텍스트를 읽을 때, 앞에서부터 읽는 것뿐만 아니라, 뒤에서부터 읽는 것도 도움이 되는 것과 같아요. 📖

인코더-디코더 모델 (Encoder-Decoder Model) ➡️ 🤖 ⬅️

인코더-디코더 모델은 하나의 시퀀스를 다른 시퀀스로 변환하는 데 사용되는 모델이에요. 텍스트 번역, 이미지 캡셔닝 등 다양한 분야에서 널리 사용되고 있어요. 인코더는 입력 시퀀스를 압축된 벡터 표현으로 변환하고, 디코더는 이 벡터 표현을 이용해서 출력 시퀀스를 생성하는 역할을 해요. 마치 번역가가 원문을 이해하고, 다른 언어로 번역하는 것과 같아요. 🌐

어텐션 메커니즘 심화 학습 🧠

어텐션 메커니즘은 RNN의 성능을 향상시키는 데 아주 효과적인 기법이에요. 어텐션 메커니즘의 다양한 종류(Self-Attention, Global Attention, Local Attention 등)와 작동 원리를 더 깊이 있게 학습해 보세요. 어텐션 메커니즘을 제대로 이해하면, RNN 모델을 더욱 강력하게 만들 수 있답니다. 💪

Transformer 모델 🚀

Transformer 모델은 어텐션 메커니즘만을 사용해서 시퀀스 데이터를 처리하는 모델이에요. Transformer 모델은 RNN의 단점을 극복하고, 더 뛰어난 성능을 보여주기 때문에, 최근 자연어 처리 분야에서 가장 널리 사용되고 있는 모델이랍니다. Transformer 모델의 구조와 작동 원리를 학습하고, 다양한 자연어 처리 문제에 적용해 보세요. 🤖

RNN의 최신 연구 동향 🔬

RNN 기술은 끊임없이 발전하고 있어요. 최신 논문을 읽고, RNN의 최신 연구 동향을 파악하는 것도 중요해요. 새로운 RNN 아키텍처, 새로운 학습 방법, 새로운 응용 분야 등 다양한 연구들이 진행되고 있답니다. 최신 연구 동향을 파악하면, RNN 기술을 더욱 효과적으로 활용할 수 있을 거예요. 📚

순환 신경망 (RNN) 기술 글을 마치며… 👋

오늘 우리는 RNN의 Vanishing Gradient 문제와 해결 방법에 대해 자세히 알아봤어요. Gradient Clipping, LSTM, GRU 등 다양한 기법들을 배우고, RNN을 제대로 사용하는 꿀팁들도 얻어 갔죠. 🍯 이제 당신은 Vanishing Gradient 걱정 없이, RNN을 자유자재로 다룰 수 있을 거예요! 🎉

RNN 기술은 앞으로도 계속 발전할 거예요. 챗봇, 번역기, 음성 인식 등 다양한 분야에서 RNN의 활약은 더욱 커질 것이라고 예상돼요. 오늘 배운 내용을 바탕으로, RNN 기술을 꾸준히 학습하고, 실전 경험을 쌓는다면, 당신도 RNN 전문가가 될 수 있을 거예요! 👩💻👨💻

이 글이 여러분의 RNN 여정에 조금이나마 도움이 되었기를 바라며, 궁금한 점이나 의견이 있다면 언제든지 댓글로 남겨주세요! 😊 그럼 다음에 또 유익한 정보로 만나요! 👋

순환 신경망 (RNN) 기술 관련 동영상

순환 신경망 (RNN) 기술 관련 상품검색